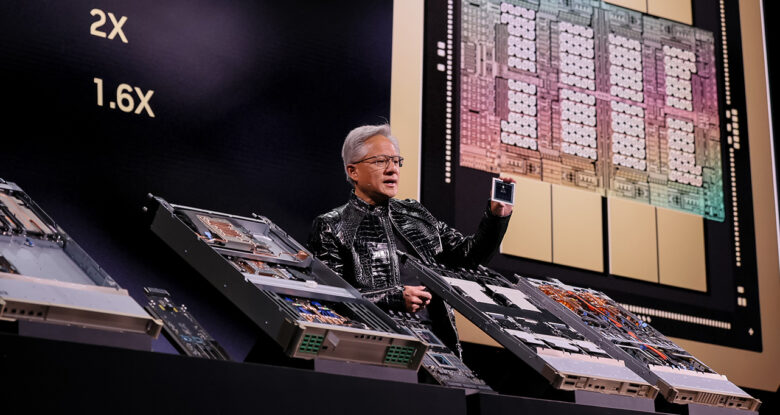

Nvidias neue Rubin-Chips sollen AI Training und Inferenz um Faktoren günstiger machen

Nvidia hat auf der CES 2026 seine neue Vera Rubin Computing-Plattform vorgestellt und damit die ursprünglich für Ende 2026 geplante Markteinführung deutlich vorgezogen. Die Ankündigung erfolgt zu einem Zeitpunkt, an dem der Chip-Hersteller mit seiner Blackwell-Generation Rekorderlöse im Rechenzentrumsgeschäft verzeichnet – ein Plus von 66 Prozent im Jahresvergleich. Das Unternehmen positioniert die neue Plattform als Antwort auf stark steigende Nachfrage nach Rechenleistung für AI-Training und Inferenz.

Die Vera Rubin-Architektur verspricht erhebliche Leistungssprünge gegenüber der aktuellen Blackwell-Generation. Laut Nvidia liefert die Rubin-GPU fünfmal mehr AI-Training-Rechenleistung als ihr Vorgänger. Bei Mixture-of-Experts-Modellen reduziert sich die benötigte GPU-Anzahl für das Training um den Faktor vier, während die Inferenz-Token-Kosten um das Zehnfache sinken sollen. Die Plattform trägt den Namen der US-Astronomin Vera Florence Cooper Rubin, deren Forschung das Verständnis des Universums grundlegend verändert hat.

Hier die Rubin-Chips im Vergleich zur Vorgänger-Linie Blackwell:

| Feature | Blackwell (B100 / B200) | Rubin (R-Serie / Vera Rubin) | Veränderung / Verbesserung |

| Status | Aktuell verfügbar (seit 2024) | Angekündigt (Jan. 2026), Release Ende 2026 | Nächste Generation |

| Fertigungsprozess | TSMC 4NP (4 nm Custom) | TSMC 3 nm (erwartet) | Kleinere Strukturbreite für mehr Effizienz |

| GPU-Speichertechnologie | HBM3e | HBM4 | Erste Generation mit HBM4 |

| Speicherbandbreite | ca. 8 TB/s | ca. 22 TB/s | ~2,8-fache Steigerung (Massiver Sprung) |

| Speicherkapazität (pro GPU) | 192 GB (B200 auch 288 GB Ultra) | bis zu 288 GB | Kapazität ähnlich, aber viel schneller |

| Interconnect (GPU-zu-GPU) | NVLink 5 (1,8 TB/s bidirektional) | NVLink 6 (3,6 TB/s bidirektional) | 2x Bandbreite für Cluster-Skalierung |

| Begleit-CPU | Grace CPU (72 Arm Neoverse V2 Kerne) | Vera CPU (88 Custom „Olympus“ Kerne) | Eigene Nvidia-Custom-Kerne statt Standard-Arm-Design |

| KI-Leistung (Training) | Basiswert (1x) | 3,5x schneller als Blackwell | Enorme Effizienzsteigerung bei großen Modellen |

| KI-Leistung (Inferenz) | Basiswert (1x) | 5x schneller als Blackwell | Entscheidend für Live-Anwendungen (z.B. ChatGPT) |

| Netzwerk-Interface | ConnectX-8 (800 Gb/s) | ConnectX-9 (1.600 Gb/s) | Verdopplung der Netzwerkgeschwindigkeit |

| Transistoren (Chip) | 208 Milliarden | ca. 1,6x mehr als Blackwell | Höhere Dichte durch 3nm Verfahren |

| Rack-System | GB200 NVL72 | Vera Rubin NVL72 | Gleicher Formfaktor, aber drastisch mehr Power |

Das Vorziehen der Rubin-Chips könnte nicht nur mit der starken Nachfrage zusammenhängen, sondern auch mit der immer größeren Frage einer AI-Blase. Einige Beobachter rechnen damit, dass diese 2026 platzen könnte – für Nvidia als wichtigstes Unternehmen im KI-Sektor ist es also wichtig, früh mit neuen Produkten am Start zu sein.

Sechs Chips für einen Supercomputer

Das System basiert auf einer engen Verzahnung von sechs spezialisierten Chips: der Vera CPU mit 88 Olympus-Kernen und Armv9.2-Kompatibilität, der Rubin GPU mit 50 Petaflops NVFP4-Rechenleistung, dem NVLink-6-Switch der sechsten Generation, der ConnectX-9 SuperNIC, der BlueField-4 DPU sowie dem Spectrum-6 Ethernet Switch. Die NVLink-6-Technologie erreicht eine Bandbreite von 3,6 Terabyte pro Sekunde je GPU, während ein komplettes Vera Rubin NVL72-Rack 260 Terabyte pro Sekunde bewältigt. Nvidia bezeichnet dies als Bandbreite, die das gesamte Internet übertrifft. Die Plattform führt zudem Confidential Computing der dritten Generation ein und gilt als erste Rack-Scale-Lösung mit durchgängiger Vertrauensarchitektur über CPU-, GPU- und NVLink-Domänen hinweg.

Nvidia bietet die Technologie in zwei Hauptkonfigurationen an: Das Vera Rubin NVL72 integriert 72 Rubin-GPUs und 36 Vera-CPUs in einem Rack-System, während das HGX Rubin NVL8 acht GPUs auf einer Serverplatine für x86-basierte Systeme kombiniert. Für Storage-intensive AI-Workloads hat das Unternehmen die Inference Context Memory Storage Platform entwickelt, die auf BlueField-4 basiert und das effiziente Teilen von Key-Value-Cache-Daten ermöglicht. Die neue Spectrum-X Ethernet Photonics-Technologie mit Co-Packaged Optics soll die Energieeffizienz um den Faktor fünf verbessern und die Zuverlässigkeit verzehnfachen.

Breite Unterstützung durch Tech-Riesen

Die Rubin-Plattform findet bereits breite Unterstützung in der Industrie. Amazon Web Services, Google Cloud, Microsoft und Oracle Cloud Infrastructure gehören zu den ersten Cloud-Anbietern, die Rubin-basierte Instanzen in der zweiten Jahreshälfte 2026 anbieten werden. Microsoft plant den Einsatz von Vera Rubin NVL72-Systemen in seinen kommenden Fairwater AI-Superfactories. CoreWeave integriert die Architektur in seine AI-Cloud-Plattform und hebt die Bedeutung für Reasoning- und Mixture-of-Experts-Workloads hervor.

Zu den AI-Entwicklern, die auf die Plattform setzen, zählen auch OpenAI, Anthropic, Meta und xAI. Die Hersteller Dell, HPE, Lenovo, Supermicro und Cisco haben angekündigt, Server auf Rubin-Basis zu liefern. Führungskräfte der Partner betonen die Bedeutung der Effizienzgewinne für die Skalierung von AI-Modellen und deren Bereitstellung für Milliarden Nutzer.

Nvidia befindet sich mit Rubin laut CEO Jensen Huang bereits in Vollproduktion. Die frühere Markteinführung unterstreicht Nvidias Strategie eines jährlichen Innovationszyklus bei AI-Supercomputern und erfolgt in einem Marktumfeld, das manche Beobachter als AI-Boom, andere als mögliche Blase bezeichnen. Produkte und Services auf Rubin-Basis werden ab der zweiten Jahreshälfte 2026 über Partner verfügbar sein.