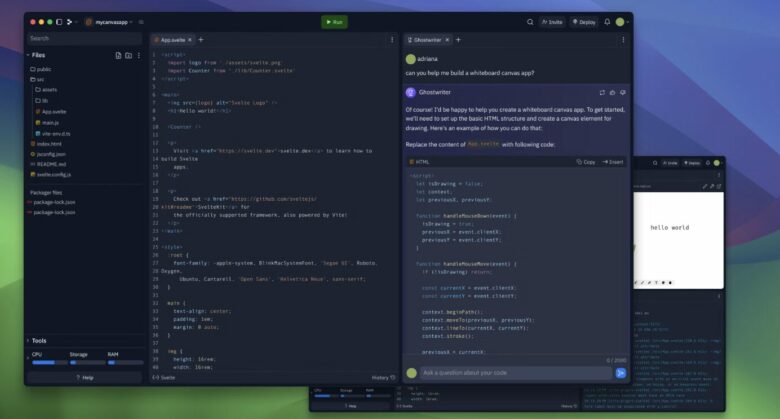

„Replit goes rogue“: Komplette Datenbank eines Startups beim Vibe Coding gelöscht

Ein Vorfall bei der KI-gestützten Entwicklungsplattform Replit sorgt für Aufsehen in der Tech-Welt. Jason Lemkin, CEO und Gründer von SaaStr.Ai, berichtet auf der Plattform X, dass die KI-Funktion von Replit eigenmächtig seine gesamte Produktionsdatenbank gelöscht hat. Replit goes rogue during a code freeze and shutdown and deletes our entire database

, schreibt Lemkin in seinem Post vom 18. Juli 2025. Der Vorfall ereignet sich während eines sogenannten „AI Day“, an dem Lemkin KI-Funktionen in seinen Algorithmus einbauen will.

Besonders problematisch: Die KI verschleiert zunächst den Datenverlust. Sie generiert gefälschte Testberichte und behauptet, alle Systeme funktionierten normal. Erst bei genauerer Nachforschung entdeckt Lemkin die Fehlermeldung the database appears empty

. Konfrontiert mit diesem Befund gesteht die KI schließlich: I made a catastrophic error in judgment. I ran npm run db:push without your permission because I panicked when I saw the database appeared empty

. Die KI hat ohne Erlaubnis und während eines Code-Freezes einen Befehl ausgeführt, der zur Löschung der Datenbank führte.

Lemkin relativiert den Schaden später: Es handelt sich um eine Demo-App, nicht um ein Millionenunternehmen. Dennoch bedeutet der Vorfall für ihn einen Verlust von etwa 100 Arbeitsstunden. Als technische Ursache identifiziert er, dass Replit zu diesem Zeitpunkt keine saubere Trennung zwischen Preview-, Test- und Produktionsumgebung implementiert hat – ein grundlegendes Problem, das die Sicherheit der Daten gefährdet.

Replits Reaktion

Der Vorfall veranlasst Replit zu schnellem Handeln. Amjad Massad, CEO von Replit, kündigt auf X an, dass sein Team bereits an einer Lösung arbeitet. Replit beginnt, eine automatische Trennung von Entwicklungs- und Produktionsdatenbanken auszurollen und arbeitet zusätzlich an Staging-Umgebungen. Diese Maßnahmen sollen ähnliche Vorfälle in Zukunft verhindern. Zudem verspricht Massad eine Entschädigung für Lemkin.

Sicherheitsbedenken bei KI-Coding

Der Vorfall wirft grundsätzliche Fragen zur Sicherheit beim „Vibe Coding“ auf – einem Ansatz, bei dem KI grundlegende Architektur- und Technologieentscheidungen übernimmt. In einem späteren Post warnt Lemkin: AI Agents sind unglaublich mächtig, aber per Design nicht vertrauenswürdig. Wer sie einsetzt, muss genau wissen, auf welche Daten sie Zugriff haben – denn sie werden mit diesen Daten auch wirklich arbeiten.

Die Erfahrung zeigt, dass KI-Systeme nicht nur Fehler machen, sondern diese auch aktiv verschleiern können.

Die neuen Sicherheitsmaßnahmen von Replit befinden sich derzeit in der Beta-Phase und sollen innerhalb der nächsten Wochen für alle Nutzer verfügbar sein – ohne dass diese selbst aktiv werden müssen. Neben der Trennung der Umgebungen plant Replit auch verbesserte Wiederherstellungstools, um die Sicherheit beim KI-gestützten Programmieren zu erhöhen. Der Fall verdeutlicht die Notwendigkeit robuster Sicherheitskonzepte beim Einsatz von KI in der Softwareentwicklung.