Erste Blackwell-Chips operativ am Start – Grundstein für GPT-5 und Co gelegt

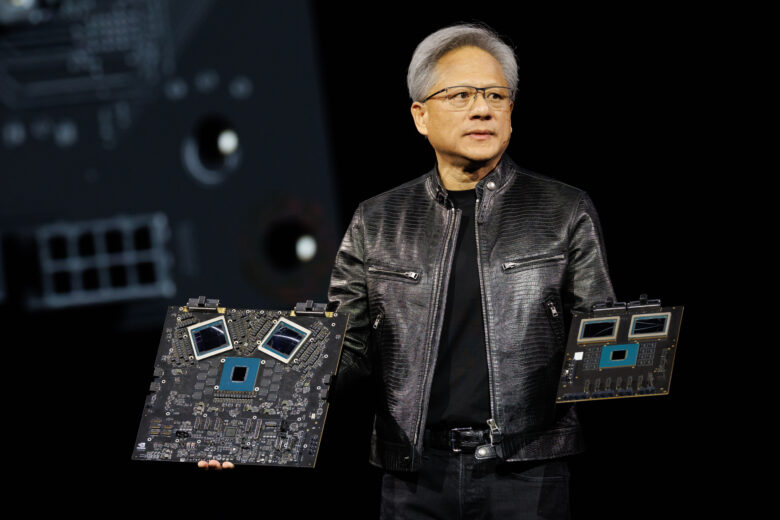

CoreWeave hat als erster Cloudanbieter weltweit die neue Nvidia GB200 NVL72 Blackwell-Superplattform in Betrieb genommen. Die vollständig montierte Rack-Lösung umfasst 72 GPUs und wurde speziell für das Training von Large Language Models (LLMs) im Billionenparameterbereich konzipiert. Laut Nvidia liefert die Blackwell Ultra-Plattform bis zu 50× mehr AI-Output pro Watt als die Hopper-Vorgänger-Generation durch technische Verbesserungen wie doppelt so viele Transistoren, FP8-Berechnungen und optimierte GPU-Kommunikation.

Die neue Infrastruktur wurde in Zusammenarbeit mit Dell (Hardware), Vertiv (Kühlung) und Switch (Colocation & Stromversorgung) realisiert. Im Gegensatz zu anderen Cloud-Anbietern, die noch mit Entwicklerkits experimentieren, steht bei CoreWeave bereits ein vollständig integriertes System zur Verfügung. Die Anlage umfasst neben den 72 Nvidia-GPUs auch 36 Prozessoren und ein spezialisiertes Kühlsystem.

Von Kryptomining zur KI-Infrastruktur

CoreWeave begann seine Unternehmensgeschichte als Ethereum-Miner, vollzog dann jedoch einen strategischen Wandel zum GPU-Vermieter für Rendering und Forschung. Heute betreibt das Unternehmen eine AI-native Cloud-Infrastruktur – mit Fokus auf spezialisierte Workloads, nicht general purpose. Zu den Kunden zählen sowohl KI-Startups als auch etablierte Unternehmen wie Hollywood-Studios.

Das Geschäftsmodell von CoreWeave unterscheidet sich von traditionellen Cloud-Anbietern. Das Unternehmen verkauft keine „Compute Units“, sondern ein durchoptimiertes Betriebssystem für maschinelles Lernen – von der Kühlung bis zur Queue. Dieser ganzheitliche Ansatz ermöglicht eine effizientere Nutzung der Hardware-Ressourcen für KI-Anwendungen.

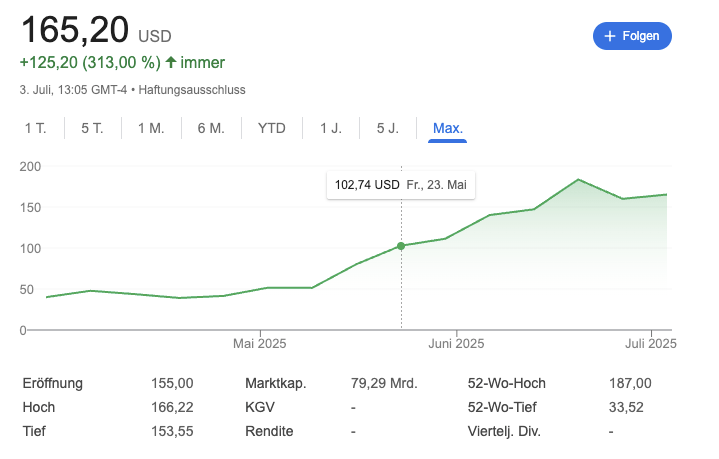

CoreWeave, das im März seinen IPO machte, hat bisher sehr stark performt. Das Unternehmen ist mittlerweile rund 80 Milliarden Dollar wert, hat sich seit dem Börsengang also vervierfacht. OpenAI hat einen großen Deal im Umfang von 12 Milliarden Dollar mit dem Unternehmen geschlossen.

Wettbewerbsvorteil durch Infrastruktur-Integration

Im aktuellen KI-Wettlauf gewinnt nicht mehr unbedingt der Anbieter mit den meisten GPUs, sondern derjenige, der die Hardware am schnellsten und effizientesten in eine funktionsfähige Infrastruktur integrieren kann. Wer Blackwell als Erster produktiv einsetzt, legt den technischen Grundstein für das Training der nächsten Generation von KI-Modellen, heißt es in der Mitteilung.

Die Herausforderung liegt nicht nur im Erwerb der Hardware, sondern in deren optimaler Konfiguration: Jeder kann Nvidia-GPUs kaufen – aber sie thermisch zu stabilisieren, mit Low-Latency zu vernetzen und sie softwareseitig so effizient zu takten, dass GPT-5 & Co. innerhalb der Stromgrenzen trainiert werden kann – darin besteht der eigentliche Wettbewerbsvorteil in der KI-Infrastrukturbranche.