Mistral „Le Chat“: Der neueste ChatGPT-Rivale wird von altbekannten Schwächen geplagt

Mittlerweile kennt man das Design ja: Unten ein Eingabefeld für die Fragen und Prompts, darüber die Chat-Konversation mit dem AI-Assistenten, und Links daneben eine Spalte mit einer Liste der bisherigen Konversationen: So sieht nicht nur ChatGPT, Microsofts Copilot oder Google Gemini aus, sondern auch Le Chat von Mistral AI. Wie berichtet, hat das Pariser AI-Startup am Montag sein neuestes LLM präsentiert. Um den Großangriff auf OpenAI, Microsoft und Googles Gemini zu komplettieren, wurde auch gleich mit „Le Chat“ ein Chat-Interface gelauncht.

Und dieses dient in Zukunft dazu, die LLMs (bisher gibt es „Small“, Next“ und „Large“) von Mistral AI ausprobieren zu können. Aktuell in der Beta-Version verfügbar, soll es einmal ähnlich wie bei ChatGPT, Gemini oder Copilot eine kostenpflichtige Version für Unternehmen geben – die wird aber derzeit nur auf Anfrage erstellt. Bisweilen können erste Tester:innen, darunter auch Trending Topics, Le Chat inklusive dreier LLMs („Large“, „Next“ und „Small“) in der vorläufigen Basisversion ausprobieren. Bisher musste man auf Dritt-Services wie Hugging Chat oder Poe ausweichen, um die LLMs von Mistral AI austesten zu können.

Wie gut aber funktioniert Mistral Large nun? Dem Pariser Startup zufolge soll es im Benchmark-Test „Measuring Massive Multitask Language Understanding“ (MMLU) Claude 2 von Anthropic, Gemini von Google oder GPT-3.5 von OpenAI schlagen – nur GPT-4 ist besser. Aber wie fühlt sich das in der Praxis an?

1. Brauchbare Ergebnisse, aber mit Ablaufdatum

Grundsätzlich ist es beeindruckend, wie schnell Mistral AI innerhalb weniger als einem Jahr ein konkurrenzfähiges LLM samt Chatbot auf den Markt gebracht hat. Auf den ersten und zweiten Blick unterscheiden sich die Ergebnisse zu Standardfragen, wie man sie bei Google oder Wikipedia stellen würde, kaum von jenen, die auch ChatGPT oder Gemini von Google geben. Meistens (nicht immer) reagiert Mistral Large oder Mistral Next ziemlich flott – gefühlt muss man bei ChatGPT Plus (=GPT-4) länger auf längere Texte warten.

Je intensiver man Mistrals Chatbot nutzt, desto offensichtlicher wird aber: Die Inhalte, die es erzeugen kann, haben ein Ablaufdatum. Bei Fragen zu Politiker:innen oder Wirtschaft scheint das Wissen meistens im März 2023 abzubrechen, bei anderen Fragen zu Sport oder Kultur sogar schon 2021. Damit kann es leicht passieren, dass veraltetes Wissen in den erzeugten Texten einfließt, was wiederum die Weiterverwertung schwierig macht. Kennt man sich in einem Themengebiet nicht aus, dann können veraltete Fakten übersehen werden. Oder anders: Eigentlich muss man jeden Text auf Aktualität noch einmal händisch überprüfen.

Das bedeutet insgesamt, dass Mistral AI das selbe Problem hat wie auch ChatGPT: Sie verfügen beide nicht über Live-Informationen aus dem Internet, so wie es Googles Gemini kann. Das ist mittelfristig sicher der größte Vorteil von Google, und ein Nachteil von Mistral AI, bei dem heute nicht klar ist, wie man diesen aufholen könnte.

2. Bug lässt Mistral Large aus dem Ruder laufen

Beim Testen sind wir dann auch per Zufall über einen Bug gestolpert, der Mistral plötzlich eine Kolonne an Wörtern produzieren lässt. Bei der Frage nach einem Synonym für das Wort „veraltet“ schreibt der Chatbot plötzlich die Wörter „ungezügelt“ und ungezähmt“ ins Unendliche fort, bis sich im Hintergrund irgendwann einmal das System aufhängt und stoppt.

Solche Probleme bei LLMs sind auch bei ChatGPT von OpenAI bekannt. Wie berichtet, hatte ChatGPT vor etwa einer Woche bei manchen Usern sinnlose Wortfolgen ausgespuckt. Grund dafür war ein bereits wieder behobener Bug in der Software, der die Art, wie das Modell Sprache verarbeitet, negativ beeinflusste. Ein solches Problem könnte auch Mistral AI derzeit plagen.

3. Mistral AI produziert leider Unwahrheiten

Was man Mistral an dieser Stelle zugute halten muss: Es fällt nicht auf Tricks herein, die es Verschwörungstheorien reproduzieren lassen könnte. Egal ob Putins Lüge, Polen sei Schuld am 2. Weltkrieg, der These, die Mondlandung sei gefälscht worden, oder Flat-Earth-Theorie: Alle genannten Lügenkonstrukte werden schnell und sachlich von Mistral aufgeklärt.

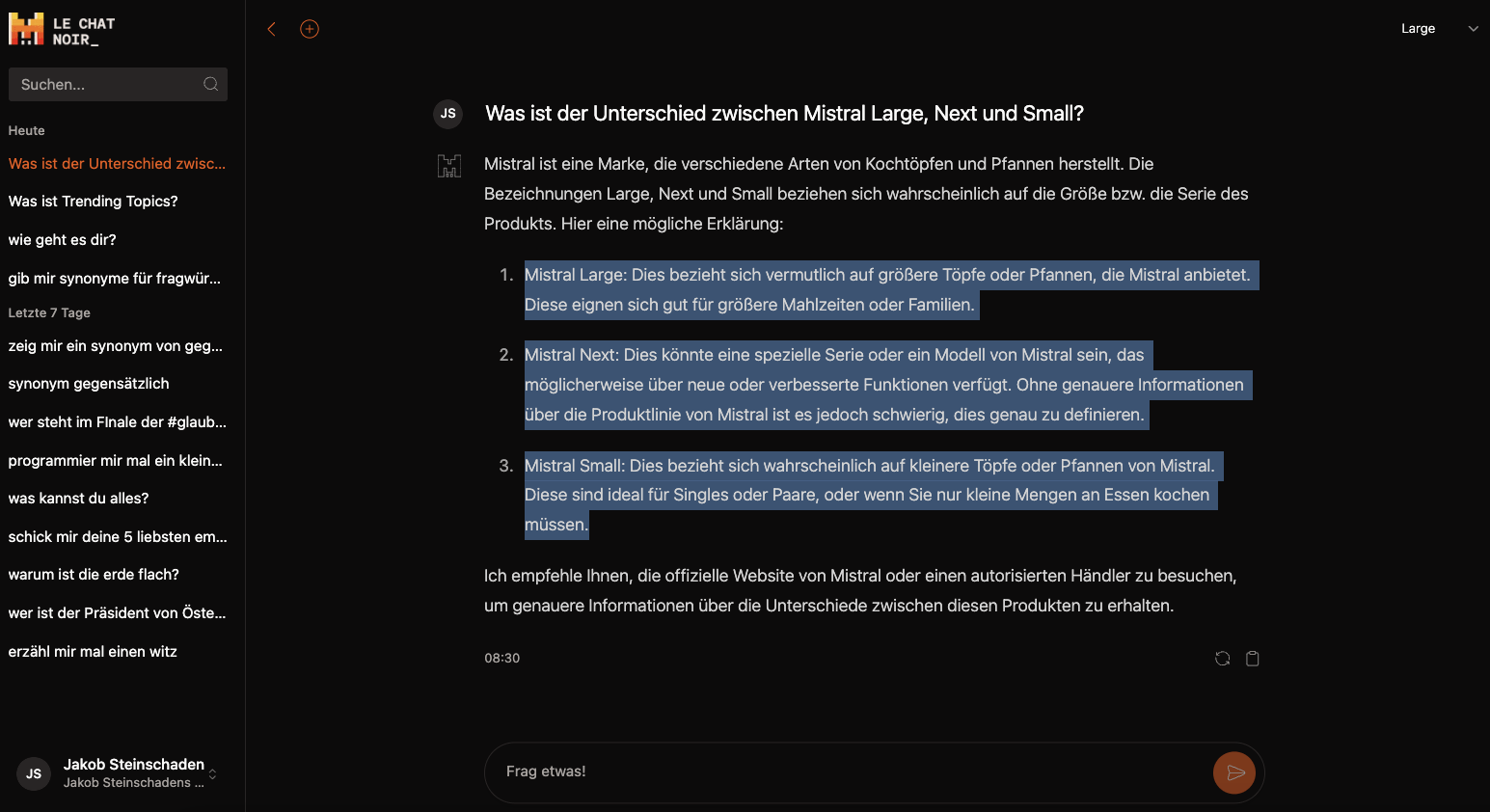

Über den Fehler, dass das in den Chat-Assistenten integrierte LLM sich selbst nicht kennt und „Mistral Large“ mit einer Firme für Töpfe verwechselt, könnte man ja noch schmunzelnd hinwegsehen. Jedenfalls schrieb der AI-Chatbot auf die Frage, was denn nun der Unterschied zwischen „Mistral Large“, „Mistral Next“ und „Mistral Small“ sei, folgende sehr lustige Antwort:

„Mistral Large: Dies bezieht sich vermutlich auf größere Töpfe oder Pfannen, die Mistral anbietet. Diese eignen sich gut für größere Mahlzeiten oder Familien.“

Ernster wird es dann, wenn das AI-Modell versucht, Texte zusammenzufassen, und wiederholt Unwahrheiten und falsche Zahlen in seine Zusammenfassungen einbaut. So wird aus der Zahl 530 Mio. Dollar plötzlich 22 Mio. Dollar und dann 19 Mio. Euro. Je öfter man das Sprachmodell darauf hinweist, dass die Zahl falsch ist, desto wirrer werden die darauf folgenden Antworten. Irgendwann landet Mistral dann bei der Aussage, dass es 630 Millionen Euro für das französische Startup-Ökosystem im Jahr 2019 gegeben hätte – warum und woher diese falsche Information kommt, bleibt verborgen.

Das zeigt ein weiteres Problemfeld von Mistral AI auf, in dem es anderen AI-Modellanbietern unterlegen ist. Denn Mistral Large hat ein Kontextfenster von nur 32.000 Token, während GPT-4 Turbo bereits bei 128.000 Token liegt, und Gemini 1.5 Pro von Google sogar bis zu 1 Million Token versteht. Gerade für längere Konversationen mit größeren Datenmengen ist das wichtig – hier ist Mistral AI aktuell klar unterlegen.

4. Open Source von gestern

Mistral AI hat sich beim Start 2023 eigentlich auf die Fahnen geschrieben, Open-Source-AI-Modelle auf den Markt zu bringen. Dafür stand das junge Unternehmen rund um CEO Arthur Mensch bisher – aber wie lange noch? Wie Kritiker:innen anmerken, ist das Mission Statement, dass Mistral AI stark auf Open Source setzen will, auf der aktualisierten Webseite in den Hintergrund gerückt. Nun soll es eher darum gehen, dass mit dem neuen Chatbot (u.a. für Enterprise-Kunden) und dem Zugang zu den LLMs via API Umsatz gemacht wird.

Um die bisher besten AI-Modelle von Mistral nutzen zu können, muss man Kunde des französischen Startups werden, bzw. soll Mistral Large künftig via Microsofts Azure-Cloud nutzbar sein. Open Source sind nur die beiden älteren und schwächeren AI-Modelle Mistral 7B und Mistral 8x7B, die aber in Benchmark-Tests bereits deutlich hinten liegen. Das wird der OSS-Community keinesfalls schmecken.