Anthropic launcht Claude 4, wird Chatbot nicht mehr weiterentwickeln

Anthropic hat mit Claude Opus 4 und Claude Sonnet 4 eine neue Generation seiner KI-Modelle vorgestellt, die insbesondere im Bereich Programmierung und komplexe Problemlösungen neue Maßstäbe setzen sollen. Auch wird kommuniziert, dass man Ende 2024 aufgehört hat, in den Chatbot zu investieren. Damit überlässt man dem dominanten ChatGPT das Feld, während man stark in Richtung B2B-Geschäft via API geht.

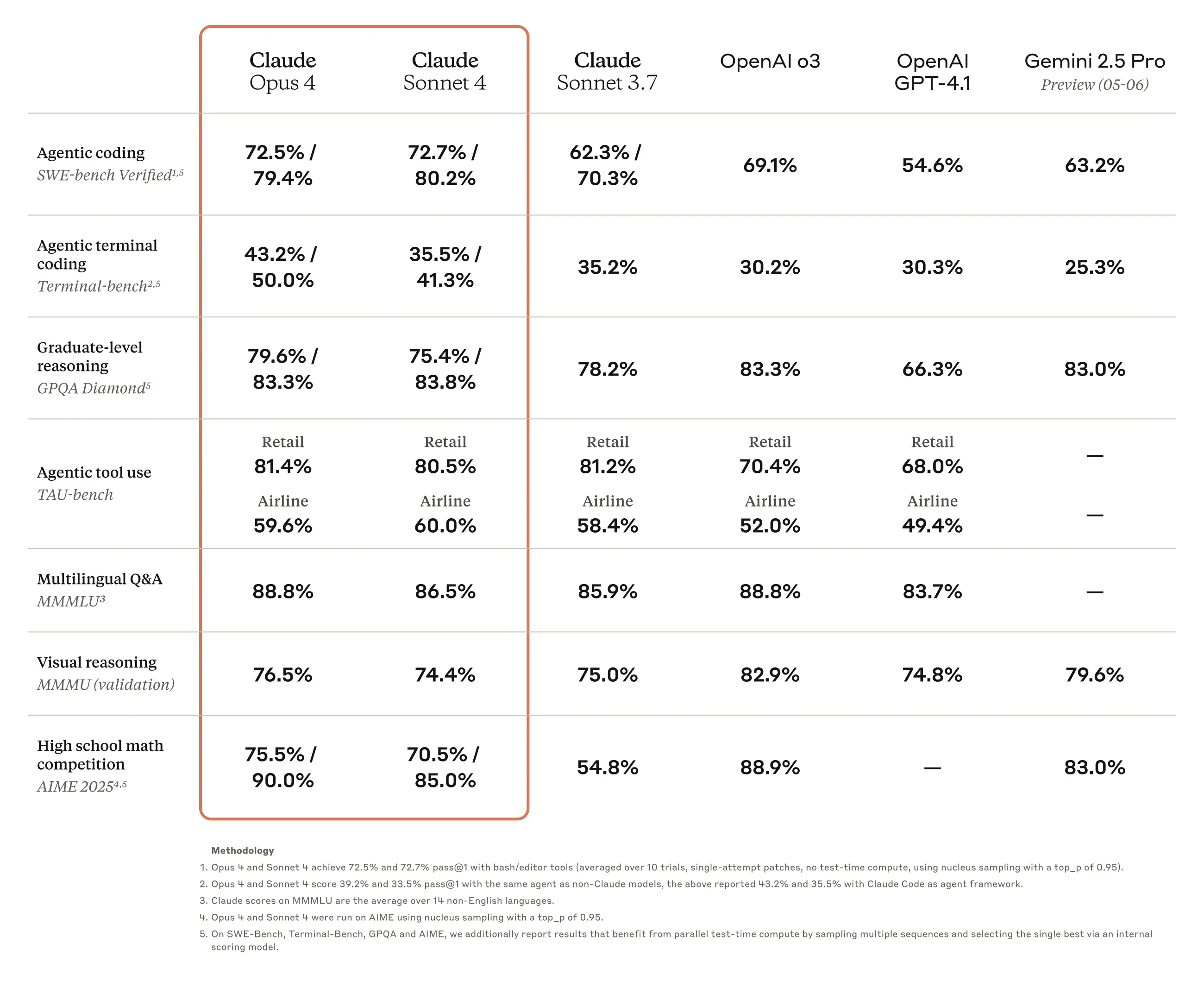

Claude Opus 4 wird von Anthropic als das „weltweit beste Coding-Modell“ bezeichnet, mit Bestwerten in Branchen-Benchmarks wie SWE-bench (72,5%) und Terminal-bench (43,2%). Die internen Benchmarks des Unternehmens zeigen, dass Opus 4 die Konkurrenzmodelle von Google (Gemini 2.5 Pro), OpenAI (GPT-4.1) und andere in Coding-Aufgaben übertrifft. Wie gut Claude 4 in der Praxis ist, wird sich weisen – in der LMArena sind die neuen KI-Modelle noch nicht gelistet.

Wer Claude 4 bereits ausprobieren will, kann das übrigens via Perplexity tun – das KI-Startup hat das neue Modell bereits für zahlende Pro-User integriert.

Bis zu 7 Stunden autonom

Eine besondere Stärke des neuen Flaggschiff-Modells liegt in der Fähigkeit, kontinuierlich über längere Zeiträume an komplexen Aufgaben zu arbeiten – in Tests konnte das Modell bis zu sieben Stunden ununterbrochen autonom tätig sein.

Claude Sonnet 4 positioniert Anthropic als effizientere Alternative für alltägliche Aufgaben. Es bietet signifikante Verbesserungen gegenüber dem Vorgänger Sonnet 3.7, insbesondere bei Coding-Fähigkeiten, ohne jedoch die volle Leistung von Opus 4 zu erreichen. In den herausgegebenen Benchmarks sieht man, dass sich Anthropic vor allem bei Coding und Agents mit anderen messen will, insbesondere Google und OpenAI:

Technische Neuerungen

Beide neuen Modelle verfügen über eine Hybrid-Architektur, die zwei Modi unterstützt:

- Nahezu sofortige Antworten für einfachere Anfragen

- „Extended Thinking“ für tiefergehende Überlegungen bei komplexen Aufgaben

Zu den wichtigsten Innovationen zählen:

- Tool-Nutzung während des Denkprozesses: Die Modelle können während ihrer Überlegungen Werkzeuge wie Websuche einsetzen, um bessere Antworten zu liefern.

- Parallele Tool-Ausführung: Die Modelle können mehrere Tools gleichzeitig nutzen.

- Verbesserte Gedächtnisfunktionen: Bei Zugriff auf lokale Dateien können die Modelle wichtige Informationen extrahieren und speichern, um Kontinuität in längeren Interaktionen zu gewährleisten.

- Reduzierte „Shortcut“-Tendenzen: Laut Anthropic sind die neuen Modelle um 65% weniger anfällig für problematische Abkürzungen und Umgehungslösungen bei der Aufgabenerledigung.

Claude Code und API-Erweiterungen

Neben den neuen Modellen hat Anthropic auch „Claude Code“ allgemein verfügbar gemacht, ein Tool für Softwareentwickler, das nun über Integrationen mit VS Code und JetBrains verfügt und Änderungen direkt in den Dateien anzeigen kann. Eine neue GitHub-Integration ermöglicht es Claude, auf Pull-Request-Feedback zu reagieren und CI-Fehler zu beheben.

Die Anthropic API wurde um vier neue Funktionen erweitert, die Entwicklern helfen sollen, leistungsfähigere KI-Agenten zu bauen. Beide Modelle sind über die Anthropic API, Amazon Bedrock und Google Cloud’s Vertex AI verfügbar. Claude Opus 4 ist nur für zahlende Kunden zugänglich, während Claude Sonnet 4 auch für kostenlose Nutzer verfügbar ist. Die Preisgestaltung bleibt konsistent mit früheren Generationen: Opus 4 kostet 15$/75$ pro Million Token (Eingabe/Ausgabe), Sonnet 4 kostet 3$/15$.

Einordnung im Wettbewerbsumfeld

Die Veröffentlichung dieser Modelle erfolgt in einem intensiven Wettbewerbsumfeld, in dem Unternehmen wie OpenAI, Google und Meta um die Führungsposition bei KI-Agenten konkurrieren. Anthropic, das zu seinen Investoren Amazon und Google zählt, versucht mit diesen Verbesserungen insbesondere im Bereich der langfristigen autonomen Aufgabenbearbeitung einen Vorsprung zu erzielen.

Branchenexperten sehen in den verbesserten Gedächtnis- und Ausdauerfähigkeiten der neuen Modelle einen wichtigen Schritt in Richtung nützlicher KI-Agenten, weisen jedoch darauf hin, dass weiterhin Sicherheits- und Zuverlässigkeitsprobleme bestehen, insbesondere wenn diese Systeme ohne menschliche Aufsicht arbeiten.