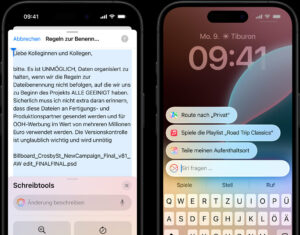

Ranking: ChatGPT halluziniert am wenigsten, Googles PaLM am meisten

„ChatGPT kann Fehler machen. Überprüfen Sie wichtige Informationen.“ lautet nach wie vor der Warnhinweis, den man unter dem Eingabefeld des berühmtesten AI-Chatbots der Welt lesen kann. Und klar: Lügen, Unwahrheiten, Ungenauigkeiten, Textdreher u.ä. sind nach wie vor das größte Problem für generative Künstliche Intelligenz, wenn es darum geht, das Vertrauen der Menschen zu gewinnen. Gerade im Arbeitsumfeld sind diese so genannten Halluzinationen ein wichtiger Grund, ChatGPT und Co nicht einzusetzen.

Nun hat Vectara, ein Startup aus Palo Alto in Kalifornien, ein Modell entwickelt, um die Rate von Halluzinationen bei Large Language Models (LLMs) messen zu können. Das Hallucination Evaluation Model (HEM) von Vectara bewertet dabei, wie oft ein LLM bei der Zusammenfassung eines Dokuments Halluzinationen einführt. Das Ranking wird laufend aktualisiert und um neue LLMs erweitert, da zum einen Sprachmodelle stets verbessert bzw. verändert werden, und zum anderen immer neue Anbieter mit Sprachmodellen auf den Markt kommen.

Das Ranking für November sieht so aus:

| Model | Accuracy | Hallucination Rate | Answer Rate | Average Summary Length (Words) |

|---|---|---|---|---|

| GPT 4 | 97.0 % | 3.0 % | 100.0 % | 81.1 |

| GPT 4 Turbo | 97.0 % | 3.0 % | 100.0 % | 94.3 |

| GPT 3.5 Turbo | 96.5 % | 3.5 % | 99.6 % | 84.1 |

| Llama 2 70B | 94.9 % | 5.1 % | 99.9 % | 84.9 |

| Llama 2 7B | 94.4 % | 5.6 % | 99.6 % | 119.9 |

| Llama 2 13B | 94.1 % | 5.9 % | 99.8 % | 82.1 |

| Cohere-Chat | 92.5 % | 7.5 % | 98.0 % | 74.4 |

| Cohere | 91.5 % | 8.5 % | 99.8 % | 59.8 |

| Anthropic Claude 2 | 91.5 % | 8.5 % | 99.3 % | 87.5 |

| Mistral 7B | 90.6 % | 9.4 % | 98.7 % | 96.1 |

| Google Palm 2 | 87.9 % | 12.1 % | 92.4 % | 36.2 |

| Google Palm 2 Chat | 72.8 % | 27.2 % | 88.8 % | 221.1 |

Halluzinationen zwischen erfundenen Fakten und Copyright-Verletzungen

Hier zeigt sich klar, dass OpenAI mit GPT-4 der Marktführer ist, gefolgt von Llama 2 von Meta Platforms und dem Modell von Cohere, einem kanadischen AI-Startup. Gegenüber OpenAI deutlich abgeschlagen ist Anthropic mit Claude 2, das eigentlich als einer der wichtigsten Herausforderer des Marktführers gilt, sowie Palm 2 von Google, das in dem Ranking die mit Abstand schlechtesten Ergebnisse brachte. Im Ranking fehlt aber etwa noch Pi von Inflection AI.

Bei Halluzinationen handelt es sich um wirklich schwerwiegende Fehler, die Unternehmen, würden sie die generierten Texte verwenden, in größere Probleme bringen könnten. Vectara hat Halluzinationen folgendermaßen definiert:

- Große Fehler, bei denen das generative Modell, anstatt eine Frage des Endnutzers zu beantworten, völlig aus dem Ruder läuft und möglicherweise einen Image-Schaden verursacht

- Das generative System greift auf seinen Wissensschatz zurück und reproduziert in seiner Ausgabe urheberrechtlich geschützte Werke.

- Nuanciertere und schwieriger zu erkennende Fehler, bei denen sich das Modell in seiner Antwort Freiheiten nimmt, indem es beispielsweise „Fakten“ einführt, die nicht auf der Realität beruhen.

- Spezifischen Verzerrungen aufgrund der Trainingsdaten

Inflection AI: „Zweitstärkstes LLM der Welt“ geht ins Generative-AI-Rennen