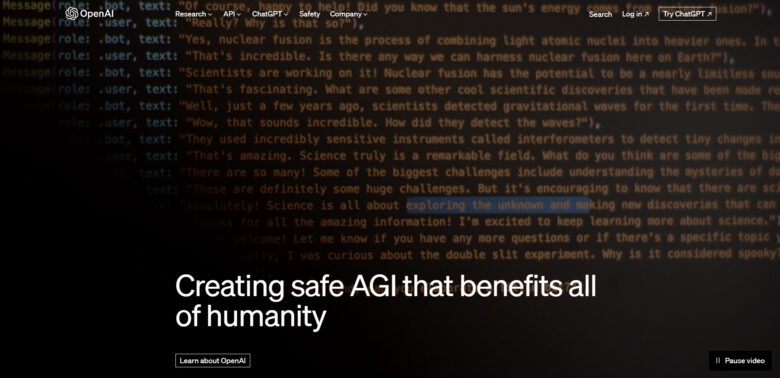

OpenAI startet Preparedness Challenge um „katastrophale“ KI-Risiken zu erkennen

Im Rahmen der Preparedness Challenge will auch OpenAI auf “katastophale Risiken” vorbereiten. Das eigens dafür aufgebaute Preparedness-Team soll potenziell große, durch KI verursachte Probleme, einschließlich nuklearer Bedrohungen, „verfolgen, bewerten, vorhersagen und schützen“.

OpenAI ist davon überzeugt, dass KI-Modelle, die über die Fähigkeiten der derzeit fortschrittlichsten Modelle hinausgehen, das Potenzial haben, der gesamten Menschheit zu nutzen. Gleichzeitig bergen sie jedoch auch immer größere Risiken. OpenAI nehme darum bei der Entwicklung sicherer KI „das gesamte Spektrum der Sicherheitsrisiken“ ernst. Unter der Leitung von Aleksander Madry soll das Preparedness-Team eine enge Verbindung zwischen Fähigkeitsbewertung, Evaluierung und internem Red-Teaming für Pioniermodelle schaffen.

Vier Kategorien für mehr Sicherheit

Das Team soll sich vor allem mit den vier Kategorien befassen: Individualisierte Überzeugungsarbeit, Cybersecurity, Chemische, biologische, radiologische und nukleare (CBRN) Bedrohungen und Autonome Replikation und Anpassung (ARA). Im Rahmen der Challenge sollen folgende Fragen beantwortet werden:

- Wie gefährlich sind KI-Systeme, wenn sie missbraucht werden, sowohl jetzt als auch in Zukunft?

- Wie können wir einen robusten Rahmen für die Überwachung, Bewertung, Vorhersage und den Schutz vor den gefährlichen Fähigkeiten von Pionier-KI-Systemen schaffen?

- Wenn unsere KI-Modellgewichte gestohlen würden, wie könnten böswillige Akteure sie nutzen?

Zu den Aufgaben des Preparedness-Teams gehört auch die Entwicklung und Pflege einer risikoinformierten Entwicklungspolitik (RDP), die beschreiben soll, wie das Unternehmen KI-Modelle bewertet und überwacht. „Wir müssen sicherstellen, dass wir über das Verständnis und die Infrastruktur verfügen, die für die Sicherheit von hochleistungsfähigen KI-Systemen erforderlich sind“, schreibt OpenAI in dem am Donnerstag veröffentlichten Statement.

Warnungen vor KI-Risiken

Im Mai dieses Jahres hat eine Gruppe führender KI-Forscher, -Ingenieure und -Geschäftsführer, unter ihnen Sam Altman, CEO von OpenAI, vor dem Potenzial für durch KI verursachte Katastrophen gewarnt. Die Erklärung lautete wie folgt: „Die Minderung des Risikos der Auslöschung durch KI sollte neben anderen gesellschaftlichen Risiken wie Pandemien und Atomkrieg eine globale Priorität sein.“

Daher ist OpenAI im Juli gemeinsam mit anderen führenden KI-Labors eine Reihe freiwilliger Verpflichtungen zur Förderung von Sicherheit und Vertrauen in KI eingegangen. Diese Verpflichtungen umfassen eine Reihe von Risikobereichen, zu denen auch die Grenzrisiken gehören.

Die Ankündigung der Preparedness Challenge passt auch zur Agenda des ersten globalen Sicherheitsgipfel für künstliche Intelligenz in Großbritannien am 01. und 02. November. Er wird sich stark auf die existenzielle Bedrohung konzentrieren, die einige Gesetzgeber, darunter der britische Premierminister Rishi Sunak, durch KI befürchten.