AI Act könnte ChatGPT, Lensa oder Vall-E als Hochrisiko einstufen

Der in Verhandlung befindliche AI Act der EU soll Potenziale und Grenzen für Künstliche Intelligenz für die Mitgliedsstaaten regeln und beruht stark darauf, dass am Ende Menschen die von den KI-Systemen erarbeiteten Entscheidungen und Inhalte kontrollieren. Doch mit welchen Tools da gearbeitet werden kann, das soll der AI Act ebenfalls stark regulieren – und könnte De-facto-Verbote für aktuell gehypte Technologien wie ChatGPT nach sich ziehen.

So will es jedenfalls der „Annex III“ des AI Act, den die Co-Berichterstatter der Gesetzesinitiative, die EU-Parlamentarier Brando Benifei und Dragoș Tudorache, eingebracht haben. Wie Euractiv berichtet, sind eine ganze Reihe an Anwendungsfällen in dem Vorschlag auf der Hochrisikoliste gelandet. Das bedeutet, dass solche „hochriskante“ KI-Technologien strenge Auflagen erfüllen müssen, bevor sie auf den Markt dürfen.

Spezifizierung der Hochrisikobereiche

Der Annex III sieht nun vor, dass unter anderem auch folgende AI-Technologien als Hochrisiko eingestuft werden sollen:

- biometrische Identifizierung und Kategorisierung durch biometrisch basierte Systeme; das würde also auch Apps wie Lensa betreffen, die Avatare auf der Grundlage des Gesichts einer Person erstellen kann

- biometrische Identifizierung in Echtzeit in öffentlichen Bereichen soll komplett verboten werden

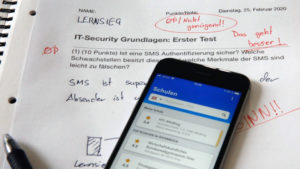

- die Zuweisung personalisierter Lernaufgaben auf der Grundlage der persönlichen Daten der Schüler:innen

- Algorithmen, die Entscheidungen im Zusammenhang mit der Anbahnung, Begründung, Durchführung oder Beendigung eines Beschäftigungsverhältnisses treffen oder unterstützen

- AI-Modelle zur Bewertung der Anspruchsberechtigung für Kranken- und Lebensversicherungen

- AI-Modelle betreffend Unterkunft, Strom, Heizung und Kühlung sowie Internet

- AI-Modelle, die vulnerable Gruppen (z.B. Kinder) betreffen

- KI-Anwendung, die die Wahlentscheidungen von Menschen beeinflussen könnte

- Jeder KI-generierte Text, der fälschlicherweise für einen von Menschen erstellten Text gehalten werden könnte, gilt als Risiko; es sei denn, er wird von Menschen überprüft und eine Person oder Organisation ist rechtlich dafür verantwortlich; würde ChatGPT, Jasper.ai und Co. betreffen

- KI-generierte audio-visuelle Inhalte, die eine Person darstellen, die etwas tut oder sagt, was nie passiert ist; Ausnahme für offensichtliche Kunstwerke; AI-Dienste wie Vall-E (Microsoft), Murf AI uvm. wären betroffen

ChatGPT lügt wie gedruckt – und will’s dann noch Trending Topics in die Schuhe schieben

Hohe Auflagen für Hochrisiko-Anwendungen

Wenn AI-Anwendungen als Hochrisiko eingestuft werden, dann müssen sie folgende Auflagen erfüllen, um auf den Markt gebracht werden zu können:

- angemessene Systeme zur Risikobewertung und -minderung

- hohe Qualität der in das System eingespeisten Datensätze zur Minimierung von Risiken und diskriminierenden Ergebnissen

- Protokollierung der Aktivitäten, um die Rückverfolgbarkeit der Ergebnisse zu gewährleisten

- ausführliche Dokumentation mit allen erforderlichen Informationen über das System und seinen Zweck, damit die Behörden beurteilen können, ob es den Anforderungen entspricht

- klare und angemessene Informationen für den Benutzer;

- geeignete Maßnahmen zur menschlichen Aufsicht, um das Risiko zu minimieren

- ein hohes Maß an Robustheit, Sicherheit und Genauigkeit

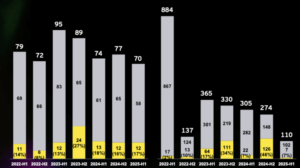

Schon bisher wurden für den AI Act folgende Hochrisikobereiche für AI definiert:

- kritische Infrastrukturen (z. B. Verkehr)

- allgemeine und berufliche Bildung, die den Zugang zur Bildung und den beruflichen Werdegang einer Person bestimmen kann (z. B. Bewertung von Prüfungen)

- Sicherheitskomponenten von Produkten (z. B. KI-Anwendung in der robotergestützten Chirurgie)

- Beschäftigung, Verwaltung von Arbeitnehmer:innen und Zugang zur Selbständigkeit (z. B. Lebenslaufsortierungs-Software für Einstellungsverfahren)

- wesentliche private und öffentliche Dienstleistungen (z. B. Kreditwürdigkeitsprüfung, die den Bürgern die Möglichkeit nimmt, einen Kredit zu erhalten)

- Strafverfolgung, die in die Grundrechte der Bürger eingreifen kann (z. B. Bewertung der Zuverlässigkeit von Beweismitteln)

- Migrations-, Asyl- und Grenzkontrollmanagement (z. B. Überprüfung der Echtheit von Reisedokumenten)

- Rechtspflege und demokratische Prozesse (z. B. Anwendung des Rechts auf einen konkreten Sachverhalt

Wann der AI Act in Kraft treten wird, ist noch nicht genau absehbar. Die Verhandlungen zur KI-Verordnung laufen noch, bei Verhandlungen am Mittwoch im EU-Parlament konnte sich noch kein Kompromiss für die genauen Punkte finden lassen. Deswegen bleibt noch abzuwarten, welche AI-Anwendungen am Ende als Hochrisiko eingestuft werden oder gar komplett verboten werden.

Glaze: US-Software soll Bilder für Dall-E und Co „unlernbar“ machen