Apple will AI direkt auf iPhones und nicht in der Cloud

Der US-Tech-Gigant Apple ist in Sachen AI derzeit im Vergleich zu Rivalen wie Google oder Microsoft eher im Hintertreffen. Doch nun will der Konzern bei künstlicher Intelligenz aufholen. Eine neue Forschungsarbeit des Unternehmens über die Ausführung großer Sprachmodelle (LLMs) auf Smartphones ist ein Indiz dafür, berichtet Ars Technica. Darin zeigt sich, dass Apple LLMs lieber direkt auf der Hardware laufen lassen will. Man wolle offenbar auf die Cloud und riesige Datenrechenzentren verzichten.

Impact AI: „Der Übergang zu einer AI-zentrierten Welt ist unvermeidlich“

Rennen um „KI-Smartphones“

Zwar hat Apple bereits 2011 mit Siri einen der ersten virtuellen Assistenten auf den Markt gebracht. Doch der Konzern hat den KI-Hype im Jahr 2023 eher passiv verfolgt. Viele in der KI-Community sind der Meinung, dass Apple hinter seinen großen Tech-Rivalen zurückbleibt. Während Microsoft und Google sich weitgehend auf die Bereitstellung von Chatbots und anderen generativen KI-Diensten über das Internet von ihren riesigen Cloud-Computing-Plattformen aus konzentriert haben, deuten Apples Forschungen darauf hin, dass sich das Unternehmen stattdessen auf KI fokussieren wird, die direkt auf einem iPhone läuft.

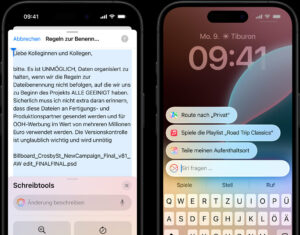

Die Idee ist nicht unbedingt neu. Beispielsweise will auch Apple-Rivale Samsung im nächsten Jahr eine neue Art von „KI-Smartphone“ auf den Markt bringen. Das Marktforschungsunternehmen Counterpoint schätzt, dass im Jahr 2024 mehr als 100 Millionen KI-fokussierte Smartphones kommen, wobei 40 Prozent der neuen Geräte bis 2027 solche Funktionen bieten werden. Anspruchsvollere virtuelle Assistenten sollen hier in der Lage sein, die Handlungen der Nutzer:innen zu antizipieren, wie das Schreiben von Textnachrichten oder das Vereinbaren eines Termins.

UNIQA: KI hat bereits 11.000 Stunden manueller Arbeit eingespart

Apple will Effizienz von LLMs optimieren

Google hat diesen Monat eine Version seines neuen Gemini LLM vorgestellt, die „nativ“ auf seinen Pixel-Smartphones laufen wird. KI-Modelle wie ChatGPT oder Google Bard auf einem persönlichen Gerät bringt enorme technische Herausforderungen mit sich. Schließlich haben Smartphones nicht die riesigen Rechenressourcen und die Energie, die in einem Rechenzentrum verfügbar sind. Die Lösung dieses Problems könnte bedeuten, dass KI-Assistenten schneller antworten als in der Cloud und sogar offline arbeiten.

Die Beantwortung von Anfragen auf dem eigenen Gerät, ohne Daten an die Cloud zu senden, dürfte auch Vorteile für den Datenschutz mit sich bringen, der in den letzten Jahren ein wichtiges Unterscheidungsmerkmal für Apple war. „Unser Experiment ist darauf ausgelegt, die Effizienz der Inferenz auf persönlichen Geräten zu optimieren“, heißt es in der Forschungsarbeit des Konzerns. Inferenz bezieht sich auf die Art und Weise, wie große Sprachmodelle auf Nutzeranfragen reagieren.

IT-Trends 2024: Fünf Prognosen zwischen Hyper-Personalisierung und „KI-Inzucht“

Intensive Forschung zu AI-Anwendungen

Die Optimierung von LLMs für den Betrieb auf batteriebetriebenen Geräten ist ein wachsender Schwerpunkt für KI-Forschende. Akademische Arbeiten sind kein direkter Indikator dafür, wie Apple seine Produkte mit neuen Funktionen ausstatten will, aber sie bieten einen seltenen Einblick in die geheimen Forschungslabors und die neuesten technischen Durchbrüche des Unternehmens.

„Unsere Arbeit bietet nicht nur eine Lösung für einen aktuellen Berechnungsengpass, sondern schafft auch einen Präzedenzfall für zukünftige Forschung“, schreiben die Apple-Forscher:innen in der Schlussfolgerung. „Wir glauben, dass LLMs immer größer und komplexer werden und dass Ansätze wie diese Arbeit unerlässlich sein werden, um ihr volles Potenzial in einer Vielzahl von Geräten und Anwendungen auszuschöpfen.“