NXAI-CEO Albert Ortig: „Werden dieses Jahr erstes kompetitives AI-Modell launchen“

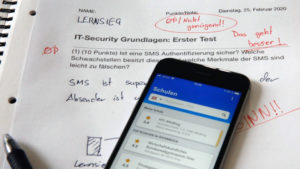

xLSTM gegen Transformer: Das ist der Wettkampf, den das Linzer AI-Startup NXAI rund um CEO Albert Ortig und Chief Scientist Sepp Hochreiter ausgerufen haben. Transformer ist jene Google-Technologie, die heute alle bekannten AI-Modelle wie GPT-4, Claude-3 oder Gemini 1.5 antreibt. Doch xLSTM soll es besser machen und unter anderem als „Edge AI“ in Fabriken, Fahrzeugen oder Flugzeugen zum Einsatz kommen – und in Simulationen.

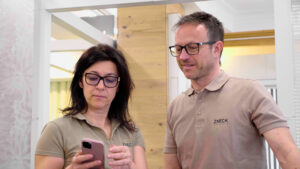

Welche Strategie NXAI hinsichtlich Finanzierung, Open Source, Marktzugang und Rechen-Power fährt, darüber spricht NXAI-CEO Albert Ortig im Interview mit Trending Topics.

Trending Topics: Welcher AI-Chatbot läuft bei dir? Ist es ChatGPT, Claude, oder doch eher Gemini?

Albert Ortig: Eigentlich alle, aber Gemini und ChatGPT sind am naheliegendsten, einfach weil sie auch früher da waren.

Du steckst ja oft hinter österreichischen internationalen Digitalerfolgen wie Storyblok oder Roomle. Jetzt bist du bei NXAI. Was ist da der rote Faden bei dir? Was treibt dich an und warum gehen so viele Dinge auf, die du angreifst?

Wir greifen sehr viele Dinge an und einige gehen auch nicht auf. Aber warum funktionieren die Dinge, die wir angehen? Ich glaube, weil wir sehr passioniert sind in dem, was wir tun. Wir versuchen über längere Zeit Signale zu verstehen und wenn sich die verstärken, dann gehen wir in diese Themenfelder rein. Das war bei Storyblok so, das war bei Roomle so, und dementsprechend war das jetzt auch im KI-Segment so. Wir haben eigentlich mit dem Start von OpenAI genauso wie der Rest der Welt unsere Heureka-Erlebnisse gehabt.

Im Sommer 2023 hat Sepp Hochreiter, mittlerweile dein Geschäftspartner, medial laut zu schreien begonnen, wie schlecht es denn um den AI-Standort und vor allem den Forschungsstandort Österreich bestellt wäre. Du hast diesen Hilferuf gelesen?

Wir haben im Juli tatsächlich unsere Company-Building-Einheit Netural X ausgegründet. Wir haben ja die bisherigen Unternehmen, also Storyblok und Roomle aus der Netural herausgegründet, und haben dann die Netural X als Unternehmen, das sich darauf fokussiert, Unternehmen zu entwickeln, gestartet. Und das macht man nicht alleine, da ist maßgeblich natürlich die Netural-Hauptgesellschaft dabei, aber da ist auch ganz maßgeblich die Familie Pierer mit dabei. Als ich dann den Sepp Hochreiter medial genauso vernommen habe wie alle anderen und er zufällig, so wie ich, auch in Linz ist, habe ich natürlich begonnen, mich damit zu beschäftigen. Warum haben wir hier offensichtlich Finanzierungsthemen haben bei einem Thema, das keine Finanzierungsthemen haben sollte. Und ich habe ihn dann tatsächlich einfach angerufen und ein Gespräch gesucht und dann haben wir einige Male gequatscht und diskutiert und sind dann zu einigen Erkenntnissen gekommen, wie es funktionieren kann und das haben wir dann umgesetzt.

„Situation für KI ist katastrophal“: Österreich bei AI-Strategie auf Entwicklungsland-Level

Daraus ist NXAI entstanden. Was ist NXAI?

Gegründet haben wir im Dezember 2023. Die ersten Gespräche waren Ende August, Anfang September. Wir haben dann innerhalb von zwei Monaten, ein komplettes Setup, Rahmenverträge, universitäre Kooperationen, also alles, was eigentlich extrem lange dauert, in sehr, sehr kurzer Zeit aufgestellt, insbesondere auch die gesamte Finanzierung. Und wir haben dann im Dezember 2023 auch zu trainieren begonnen. Zeit ist ein ganz zentrales Element in dem Spiel.

Was macht NXAI nun?

Vereinfacht gesagt haben wir zwei zentrale Elemente in der NXAI. Das eine ist ein Forschungsreaktor mit den weltbesten Forschern in zwei Segmenten, nämlich im Large Language Model-Bereich mit xLSTM und im Simulationsbereich „AI4Simulation“. Wir haben einerseits einen ganz stark fokussierten Forschungsaspekt, wirklich Grundlagenforschung, und das wollen wir ausbauen. Das soll größer werden und da kooperieren wir mit der Uni in Linz und der JKU und machen auch zusätzliche Kooperationen in ganz Europa und durchaus auch außerhalb, wenn es sich ergibt.

Der zweite große Aspekt in der NXAI ist: Wir wollen diese Hochtechnologie in die Industrie transformieren. Das heißt, der zweite Part ist Transformation der Technologie in Business und in Produkte, Industrie-Verticals. Dementsprechend bauen wir gerade Teams auf, die auf der Forschungsseite spitzenmäßig sind und auf der Produkt- und Transformationsseite von Technologie in Produkt top sind.

Wie kann man sich dieses Produkt am Ende vorstellen? Jetzt kennt ChatGPT. Läuft das bei euch ähnlich oder ist es was komplett anderes?

Da unterscheiden wir uns tatsächlich komplett von den relevanten Playern. Wahrscheinlich gibt es zwei Handvoll wirklich relevante Technologien am Markt. Diesen Technologien gemeinsam ist eine Grundlagentechnologie, die Transformer heißt und diese Transformer-Technologie hat damals, 2017, eigentlich Google erfunden. Mit dieser Technologie wurde das LSTM von Sepp Hochreiter mehr oder weniger abgelöst, weil diese Technologie ein zentrales Thema lösen konnte: nämlich gleichzeitig ganz viel Kontext und Content trainieren. Das geht mit LSTM nicht, da arbeitet man sich sozusagen in Sequenzen durch. Alle diese Technologiefirmen, die diese tollen Produkte auf dem Markt haben, verwenden Transformer-Technologie.

Also OpenAI, Anthropic, Mistral, aber ihr nicht.

Genau, wir nicht. Uns unterscheidet, dass wir eine eigenständige neue Technologie neben Transformer hinstellen. Wir sind ganz an der Basis der Grundlagentechnologie. Wir können die Probleme, die LSTM im Vergleich zu Transformer hat, und die Vorteile, die Transformer und LSTM haben, zusammenbringen. Das Ergebnis ist xLSTM. Und damit unterscheiden wir uns fundamental. Unser Produkt ist jetzt im ersten Schritt eine Grundlagentechnologie und noch kein Modell, mit dem man über API spielen kann. Wir bauen jetzt natürlich die Modelle drauf. Wir trainieren die Grundlagentechnologie jetzt mit Daten und bauen damit Modelle, und diese Modelle werden wir auch zur Verfügung stellen. Dort ergeben sich dann unterschiedliche Geschäftsfeldpotenziale, die im ersten Schritt eher nicht die sind, wo die etablierten Player mit vielen Milliarden und ein paar Jahren Vorsprung jetzt sehr, sehr erfolgreich und durchaus auch sehr gut sind.

NXAI: Linzer AI-Startup von Sepp Hochreiter zeigt erstmals den GPT-Konkurrenten xLSTM

Welche sind das dann?

Wenn ich bei einem Transformer-Modell große Fragestellungen, große Kontexte eingebe, wirkt sich diese exponentielle Compute im Betrieb massiv aus, weil desto mehr Menschen gleichzeitig mit größeren Kontexten reingehen, desto stärker steigt die Notwendigkeit von GPU-Leistung und damit auch von Kosten. Wir steigen bei xLSTM linear: Je größer der Kontext ist, der in diese Modelle reinkommt, desto effizienter ist unser Modell, und zwar um ein X-faches effizienter. Da sind wir gerade auch noch dabei, wissenschaftlich auch klar herauszuarbeiten, wie viel, aber es ist relevant deutlich, also wirtschaftlich und anwendungstechnisch relevant.

Wir sind in der Inference, in der Laufzeit massiv effizienter und wir haben die Möglichkeit, sehr, sehr große, eigentlich nach oben offene Kontext-Windows in das Modell zu bringen. Dann gibt es noch eine dritte Komponente, die wir sehr spannend finden. LSTM, also die Ursprungstechnologie, die der Sepp Hochreiter in den 90er Jahren erfunden hat, die ist inhärent fähig, Time-Series-Daten zu verarbeiten. Sie versteht Datenpunkte auf einem Zeitstrang, weil wir ja auch sequenziell durcharbeiten, und dementsprechend versteht man inhärent Zeitreihen. Ein Transformer-Modell muss das trainieren, also muss ganz viele Zeitreihen gesehen haben und dann schätzt es, ob das, was trainiert wurde, richtig ist oder nicht, aber es kann es eigentlich nicht berechnen.

Wir sind hier in Oberösterreich oder, wenn man so will, im Produktionszentrum in Europa, wenn man die deutschen Zentren, die Schweiz und Oberitalien dazunimmt. Da ist sehr viel Industrie und das Thema Industrie interessiert uns natürlich. Wir können mit dem Modell potenziell auf den Laufzeitcomputern in der Produktion sein, auf den Geräten sein, also on the edge sein, das ist etwas, wo wir gerade sehr genau hinschauen. Wenn man sich viele Sensorendaten, die live daherkommen, in einer Produktion vorstellt, die auch zeitrelevant sind, und die kombiniert mit anderen Kontexten und das aber nicht über die Cloud, sondern on-site laufen sollte. Das kann man umlegen auf ganz viele Anwendungsfälle, ob das jetzt im Auto ist, ob das jetzt im Flugzeug ist, ob das jetzt an der Maschine ist oder auf einem Gerät ist und natürlich alles, was große Kontext-Windows in Kombination mit Low Inference erfordert.

Das hört sich danach an, dass es eine künstliche Intelligenz sein kann, die ein Auto oder sogar eine ganze Fabrik steuern könnte.

Soweit würde ich aus der Perspektive der NXAI noch gar nicht gehen, weil wir davor ansetzen, also nicht in der Anwendung selber, sondern in den Algorithmen und in den Modellen, die dann dafür verfügbar werden, um bestimmte Dinge on the edge, also dort, wo es stattfinden soll, live zu berechnen oder zu berechnen.

Um einen Vergleich zu ziehen: Die Transformer-Technologie ist dann irgendwie Windows und ihr seid der Mac?

Ein schmeichelnder Vergleich. Ich glaube, wir sind einfach eine andere Generation von Technologie. Wir sind jetzt eine Generation, die sieben Jahre nach der Transformer-Technologie entwickelt wird und wir sehen, dass wir fundamentale Mehrwerte aus einer neuen Architektur ziehen können. Das versuchen wir auf den Boden zu bringen und insofern unterscheiden wir uns einfach von den anderen, wenngleich das nicht bedeutet, dass wir uns unterscheiden in der Notwendigkeit letztlich auch Business zu machen.

Ihr seid in der Grundlagenforschung und macht gleichzeitig Business on top. Wie viele Hundertschaften an Menschen sind da mittlerweile bei euch beschäftigt, um das alles bewerkstelligen zu können?

Da braucht es gar nicht Hundertschaften an Menschen. Man braucht einige wirklich sehr, sehr gute Spitzenforscher, man braucht ein Business-Team und man braucht ein Produkt Team. Wir sind im Dezember im Wesentlichen zu dritt gestartet, sind jetzt insgesamt knapp 15, nächstes Monat werden wir wahrscheinlich 20 sein und bis Ende des Jahres sollten wir 30 sein.

Das finde ich immer wieder beeindruckend, dass gerade solche Unternehmen mit relativ kleinen Teams zurechtkommen. Mistral AI in Paris, die haben mittlerweile eine Bewertung von 6 Milliarden Euro und nicht mal 50 Mitarbeiter. Was sagt uns das über die Zukunft der Arbeit, wenn so ganz kleine Teams so viel bewerkstelligen können?

Ich würde sagen, sagt vordergründig mal, dass dieses Themensegment derzeit crazy ist. Was man nicht unterschätzen darf und was momentan oft gerne in den Diskussionen übersehen wird, ist, dass das extrem Anlagen-intensiv ist. Also das ganze Geld, diese ganzen Millionen und Milliarden, die gehen ja nicht in die Köpfe, sondern die gehen in die ganze Compute. Es ist ein Wettrüsten. Wir müssen massiv Kapital in Compute investieren, sonst können wir die Modelle gar nicht trainieren, sonst können wir sie nicht auf den Markt bringen, dann sind wir nicht relevant und dann kannst du 500 Köpfe haben, das bringt dann nichts.

Insofern ist das ein wenig wie Pharma. Es wird mit sehr hohem Risiko, sehr, sehr viel Kapital in ein Themensegment investiert, und das sichert man ab mit den besten Köpfen. Das ist eigentlich das, was da gerade stattfindet.

Wenn wir über Compute, über Anlagen sprechen, dann meinst du jetzt wahrscheinlich diese GPU-Rechner von NVIDIA.

Kaufen tut man die normalerweise gar nicht, aus zweierlei Gründen: Erstens, weil du ja nicht nur diese Chips brauchst, sondern du brauchst zu den Chips auch die Infrastruktur, also die Hallen und du brauchst zu diesen Hallen die Kühlung und du brauchst zur Kühlung und zu den Hallen den Strom. Wenn wir tausend GPUs kaufen würden, dann ist das mehr, als in ganz Österreich gerade eine Instanz zur Verfügung hat. Derzeit ist eigentlich der Way to go, in diesem Bereich über Hyperscaler und andere Anbieter diese Compute zuzukaufen.

Das heißt, dass diese Hyperscaler nicht viel Umsatz machen mit Copilots und Co, sondern mit ihren Rechenzentren haben, wo sich viele Firmen auf dem ganzen Planeten einmieten, um Zugang zu dieser Rechenpower zu bekommen.

Nvidia hat ein bestechendes Business-Modell. Es gibt auch andere, die tolle Chips haben, aber Nvidia einen Zeitwettbewerbsvorteil. Sie haben Software-Technologie entwickelt, auf der die gesamte KI-Industrie entwickelt. Diese CUDA-Kernels, die du mit CUDA als Programmiersprache programmierst, laufen nur auf Nvidia-Chips. Man kann natürlich auf anderen Chips trainieren und mit anderer Technologie, aber das bedingt ein Umrüsten, und das bedeutet Zeit, und diese Zeit ist nicht da. Das ist momentan das, was Nvidia so beflügelt. Wenn du wettbewerbsfähig sein willst, dann hast du wenig Zeit zum Experimentieren, was diese Programmiertechnologien und Chips betrifft.

Die Hyperscaler investieren in diese Riesenmodelle, weil sie sehen, dass sie über Compute ihr zukünftiges Business abbilden können, weil diese Modelle alle viel Inference, also viel laufende Computern brauchen Wenn die ein großes Modell trainieren um viele Milliarden Dollar, dann bringt es noch viel mehr Milliarden Dollar im Laufzeitbetrieb.

Ihr müsst in diesem Rennen ja auch mithalten. Wie viel Kapital braucht man, um das machen zu können, was ihr machen wollt?

Wir sind schon mit einem zweistelligen Millionenbetrag gestartet. Unsere Pre-Seed-Runde ist größer als die meisten Series A-Runden, und der Plan ist, dass wir bis Ende des Jahres zusätzlich eine große Runde machen. Wie groß die ist, kann ich noch nicht sagen, aber relevant. Wir sind aber jetzt sehr, sehr gut aufgestellt, auch was unsere Finanzmittel betrifft, also wir sind so gut durchfinanziert, dass wir da in Ruhe diese Finanzierungsthemen abarbeiten können. Wir sehen extrem hohe Nachfrage, und wir sind da sehr zuversichtlich, formulieren wir es mal so.

Eine Pre-Seed-Runde in der Höhe von oder größer als Series A. Reden wir da davon 50 Millionen plus?

Ganz so viel ist nicht, aber ein relevanter Teil von den 50 ist es schon.

Wann könntet ihr ein eigenes LLM launchen?

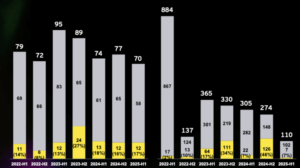

Wir stehen jetzt dort, dass wir mit dem Paper ein 1,3 Milliarden-Parameter-Modell trainiert haben, aber wir brauchen für das Business mindestens 7 Milliarden Parameter bis zu 30 Milliarden Parameter. Unser nächster Schritt ist natürlich, diese 7 Milliarden und 30 Milliarden Modelle zu trainieren und dann auf den Markt zu bringen. Der Plan ist schon, dass wir dieses Jahr noch ein erstes kompetitives Modell, also zumindest ein 7 Milliarden Modell verfügbar haben werden.

NXAI: „Wir wollen Linz zu einem Player machen, der weltweit anerkannt ist“

Welche Strategie wählt ihr da: proprietär oder Open Source?

Ich glaube, es ist recht klar, dass der Open Source-Weg in der KI-Modellperspektive wirtschaftlich schwer funktionieren wird. Das leistet sich Apple und das leistet sich Meta. Alle anderen haben zugemacht. Apple launcht ein Modell, damit sie diese ganze Entwickler-Community onboarden. Man wird nicht drumherum kommen, Spielplätze zur Verfügung zu stellen. Das haben wir auch schon gemacht. Das werden wir auch weiterhin tun, aber wir werden, so wie es jetzt aussieht, nicht den Open Source-Weg bestreiten.

Wenn du auf Europa blickst, da gibt es natürlich ein paar Player wie Silo AI, Mistral AI oder Aleph Alpha. Man hat in den letzten Wochen gesehen, dass sich die alle miteinander verbünden. Wie deutest du das?

Ich glaube, wir müssen in Europa Partnerschaften schließen. Wir dürfen uns nicht als Mitbewerber sehen. Das kann man da und dort sein und das ist klar, dass man sozusagen da und dort auch in einer Competition ist, aber ich halte es für überaus erforderlich, dass Europa sich zusammenschließt, um das aufzuholen, wo wir hinten sind und da braucht es alle Kräfte und das können nicht wir alleine. Das kann nicht Mistral alleine, das kann nicht Silo alleine. Die Forscher, die kennen sich alle und es ist naheliegend, dass man sich verbündet. Deshalb sagen wir auch nicht, wir sind ein Linzer KI-Unternehmen oder ein Linzer KI-Modell, sondern wir haben eine europäische Perspektive.

Das heißt: Mistral, Silo, Aleph Alpha sind potenzielle Partner für unterschiedliche Use Cases?

Ja, absolut. Das schließen wir gar nicht aus. Nachdem wir ja auch eine Grundlagentechnologie haben, also etwas, was man unten drunter dann auch potenziell austauschen und nützen kann, ist es etwas, was wahrscheinlich für alle Player interessant sein kann.

Wenn wir uns in einem Jahr wieder zusammensetzen, was ist dann bei NXAI passiert, auf was wirst du dann stolz sein?

Ich hoffe, dass wir dann einerseits das Team beisammen haben, wie wir uns das jetzt wünschen, aber da sind wir gut am Weg und das Wichtigste ist, dass mit unseren beiden Themen, also die Simulation und das Large-Language-Model, tatsächlich auch schon industriell in Anwendung sind und damit auch ordentlich Umsätze erwirtschaften.

Dieses Simulationsthema, wie kann man sich das vorstellen?

Unser Johannes Brandstetter war einer derjenigen, der dieses neue Wettermodell von Microsoft in Amsterdam entwickelt hat. Dieses Wettermodell schlägt alle bestehenden Wettermodelle, und zwar über Daten und nicht nur über Physik. Dort gibt es Entwicklungen, die wir jetzt in der NXAI mit dem Johannes zu einem Foundation Model ausbauen, da geht es um Partikel-Simulationen, da geht es um Fluid Dynamics-Simulationen, alles das, was du eigentlich in jeder Industrie-Simulation brauchst. Dort gibt es Limitierungen, die seit jeher gelten. Da geht es darum, wie viele Partikel kannst du live simulieren, wie lange dauert das und wie präzise ist die Simulation. Da arbeitet man daran, dass man dort diese Grenzen massiv verschiebt. Also wir werden dort eine massive Veränderung haben, wie man zukünftig simuliert. Das Ziel wäre, dass man im Herbst da tatsächlich ordentlich was präsentieren kann.