GPT-4 ist da: AI-Modell wird trotz Verbesserungen weiter „halluzinieren“

Schon im Vorfeld wollte man die Erwartungshaltungen ein wenig zügeln; dennoch ist der heutige Launch von GPT-4, dem neuesten KI-Modell des Startups OpenAI, ein viel beachtetes Ereignis auf der ganzen Welt. Mit GPT-3.5 haben hunderte Millionen Menschen bereits Bekanntschaft gemacht, und zwar in Form von ChatGPT. Unwissentlich gibt es bereits viele Millionen GPT-4-Nutzer, denn die KI ist bereits in Bing Chat integriert und damit Bestandteil der Suchmaschine von Microsoft.

Die ersten, die GPT-4 nutzen werden können, sind die zahlenden ChatGPT-Plus-User. Sie sollen aber auch gleich eine Nutzungsobergrenze je nach Nachfrage und Systemleistung bekommen, weil die Kapazität zu Beginn stark eingeschränkt sein wird. Außerdem wird es eine API geben, für die man bezahlt (Der Preis beträgt $0,03 pro 1k Prompt-Token und $0,06 pro 1k Completion-Token). „Wir hoffen auch, irgendwann eine gewisse Anzahl von kostenlosen GPT-4-Abfragen anbieten zu können, damit auch diejenigen, die kein Abonnement haben, es ausprobieren können“, heißt es aus dem Unternehmen.

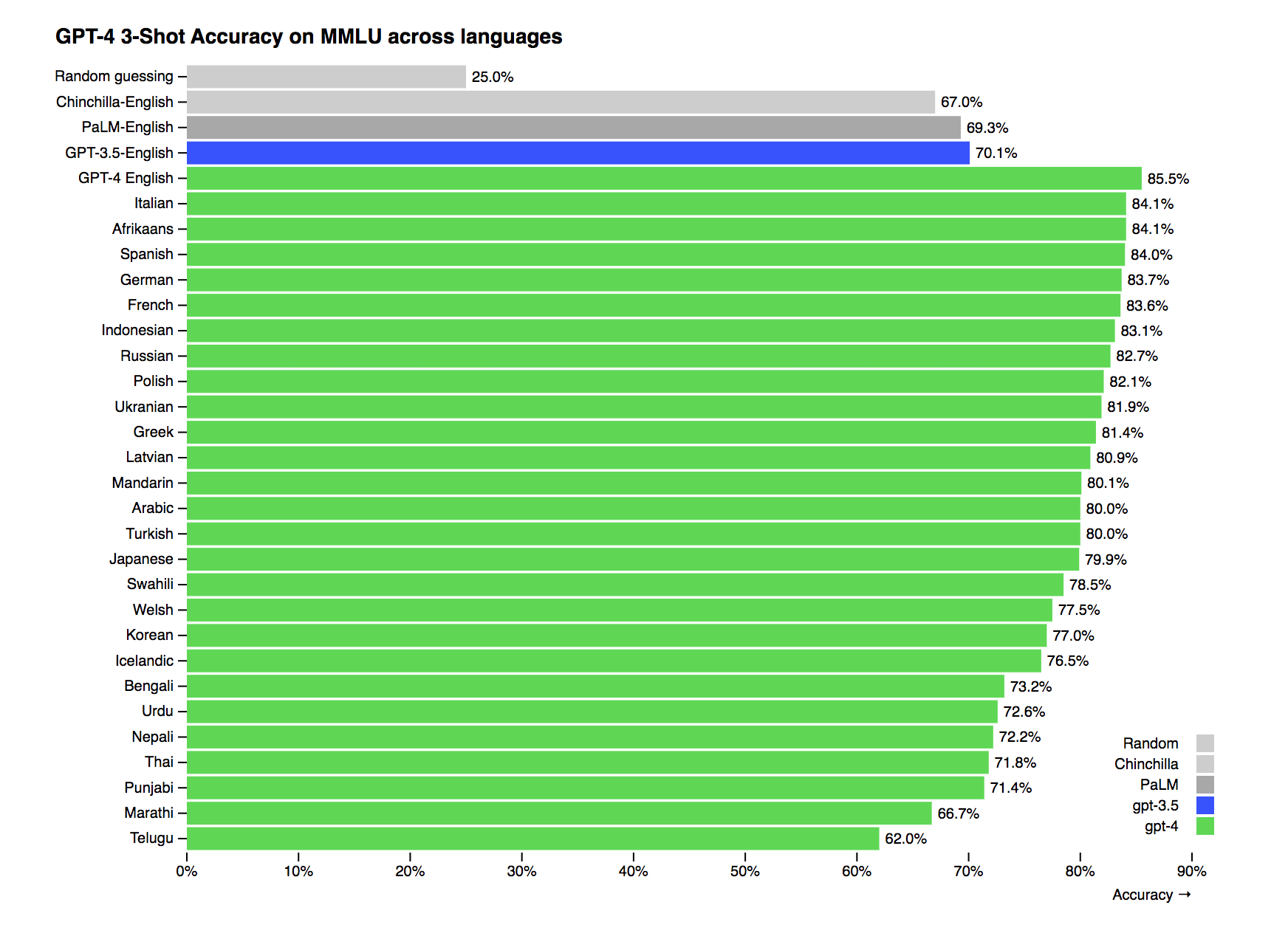

Bessere Sprachverarbeitung als PaLM von Google

Mit GPT-4 will das Unternehmen rund um CEO Sam Altman nun aufs nächste Level kommen. Das Kürzel ist aber nicht mehr LLM (Large Language Model), sondern viel mehr LMM für „Large Multimodal Model“. Denn GPT-4 kann auch Bilder als Inputs verarbeiten. Bedeutet: Man kann das AI-Modell mit Fotos, Grafiken oder Screenshots füttern, und es kann dann den dort enthaltenen Text verarbeiten. Beim Output bleibt es bei Text bzw. Code, Bilder kann GPT-4 (anders als etwa Stable Diffusion oder Dall-E) nicht generieren.

Natürlich brüstet sich OpenAI damit, einmal mehr einen „Meilenstein“ abgeliefert zu haben. In Tests soll GPT-4 besser abschneiden als GPT-3.5 (wenig überraschend), aber viel wichtiger ist Folgendes: Das neue MML soll besser als PaLM von Google sein, und zwar nicht nur auf Englisch, sondern in einer Vielzahl an Sprachen, darunter Italienisch, Spanisch, Deutsch oder Französisch. Das ist natürlich ein ordentlicher Affront gegen Google, das derzeit versucht, PaLM („Pathways Language Model“) durch die geplante Integration in Google Docs oder Gmail den Massen schmackhaft zu machen. Den Trick mit den Bildern soll PaLM übrigens auch können und später einmal Bilder für Präsentationen generieren können.

Kaum Unterschiede zu GPT-3.5

Aber zurück zu GPT-4. Den besten Vergleich, den man zum neuen KI-Modell ziehen kann, ist jener zu seinem Vorgänger GPT-3.5, der bereits an mehreren Stellen zu arbeiten begonnen hat. „In einem lockeren Gespräch kann der Unterschied zwischen GPT-3.5 und GPT-4 sehr subtil sein. Der Unterschied tritt zutage, wenn die Komplexität der Aufgabe eine ausreichende Schwelle erreicht – GPT-4 ist zuverlässiger, kreativer und in der Lage, viel differenziertere Anweisungen zu verarbeiten als GPT-3.5“, heißt es dazu seitens OpenAI.

Der wichtigste Unterschied zu GPT-3.5 wird für den Normalnutzer dann eben der Bild-Input sein. So kann man etwa ein Foto eines Kabels an einem Smartphone hochladen, und GPT-4 kann darauf erkennen (und anschließend in Worten beschreiben), dass da gerade ein VGA-Connector an einem Smartphone steckt.

OpenAI wird in der Präsentation von GPT-4 aber nicht müde zu erklären, dass das Modell viele Fehler hat und bei weitem nicht perfekt ist. „GPT-4 birgt ähnliche Risiken wie frühere Modelle, z. B. die Generierung schädlicher Ratschläge, fehlerhaften Codes oder ungenauer Informationen“, so OpenAI. „Trotz seiner Fähigkeiten hat das GPT-4 ähnliche Einschränkungen wie frühere GPT-Modelle. Am wichtigsten ist, dass es immer noch nicht völlig zuverlässig ist, es „halluziniert“ Fakten und macht Denkfehler.“

GPT-4 kennt die Welt nur bis September 2021

Man hätte sich mit aber mit 50 Experten aus Bereichen wie KI-Anpassungsrisiken, Cybersicherheit, Biorisiko, Vertrauen und Sicherheit sowie internationale Sicherheit zusammen getan, um bestimmte risikoreiche Inhalte einzuschränken. So etwa wird GPT-4 Anfragen zur Synthese gefährlicher Chemikalien ablehnen – also keine Anleitung zum Bombenbauen oder Giftmischen liefern.

Wie auch bereits bei GPT-3 gibt es auch Limitationen, was das „Wissen“ der KI angeht. „GPT-4 fehlt im Allgemeinen die Kenntnis von Ereignissen, die nach der überwiegenden Mehrheit seiner Daten (September 2021) eingetreten sind, und er lernt nicht aus seinen Erfahrungen. Manchmal unterlaufen ihm einfache Denkfehler, die mit seiner Kompetenz in so vielen Bereichen nicht vereinbar sind, oder er ist übermäßig leichtgläubig, wenn er offensichtlich falsche Aussagen eines Benutzers akzeptiert“, so OpenAI. „Und manchmal kann es bei schwierigen Problemen genauso versagen wie Menschen, z. B. indem es Sicherheitslücken in den von ihm produzierten Code einbringt.“

Wir haben ChatGPT nach Startup-Ideen gefragt, damit du nicht nachdenken musst